A/B Testing (oder auch Split Testing genannt) kommt vor allem im Online Marketing vor. Das Ziel eines A/B Tests ist meistens die Erhöhung der Conversions: mehr Kontaktanfragen oder Käufe im Onlineshop. Oft spricht man auch von Conversion Rate Optimierung. Beim A/B Testing werden zwei Versionen gegeneinander getestet in der Hoffnung, dass die „neue“ Version zu einer Verbesserung der Conversion Rate und somit zu mehr Umsatz führt. Die „Versuchspersonen“ sind dabei deine Website-Besucher.

In jedem Fall ist A/B Testing eine wissenschaftliche Methode: Denn nur mit sinnvollem und mathematisch fundiertem A/B Testing lassen sich auch wirklich Aussagen über Veränderungen in der Conversion Rate treffen.

Was A/B Testing genau ist, wieso du dir das näher anschauen solltest und worauf du achten musst, erkläre ich dir in dem folgenden Artikel.

A/B Testing: Definition und Erklärung

Stell dir folgendes Szenario vor:

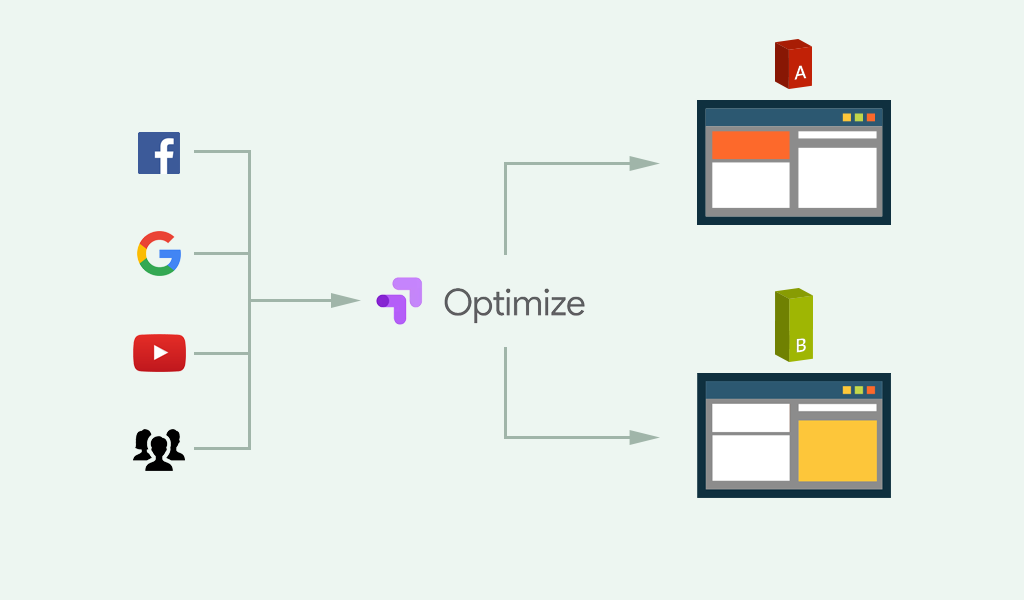

Dein Unternehmen generiert viel Traffic für seine Website oder seinen Onlineshop durch unterschiedliche Kanäle: Facebook, Google, Pinterest, YouTube. Egal, ob bezahlt oder organisch. Doch der ganze eingehende Traffic deiner Website konvertiert einfach nicht so gut wie gewünscht. Dabei ist mit „Konvertieren“ nicht unbedingt ein Kauf im Onlineshop gemeint. Auch das Absenden einer Kontaktanfrage, eine Newsletter-Anmeldung oder der Download eines eBooks zählen dazu (Weitere Beispiele findest du im Artikel zur Conversion Optimierung).

Eine geringe Conversion Rate kann verschiedene Gründe haben: Von einer schlechten Usability oder User Experience deiner Website bis zu psychologisch bedingten Problemen sind etliche Gründe eine potenzielle Antwort auf die Frage.

Und genau da setzt A/B Testing an. Mit Hilfe von A/B Tests (Split Test) kannst du systematisch Probleme deiner Website bzw. deines Onlineshops ausmerzen.

Dabei ist das grundlegende Prinzip denkbar einfach:

Zur Optimierung deiner Conversion Rate möchtest du eine Veränderung auf deiner Website testen. Die aktuelle Website ist Version A (auch Originalversion genannt). Die Veränderung, die du in einem A/B Testing Tool erstellst, ist Version B (auch Variante genannt).

Nachdem du die veränderte Version B fertiggestellt hast, wird der eingehende Traffic von deinem A/B Testing Tool (meist 50:50) in Gruppe A und Gruppe B geteilt. Diese beiden Gruppen erhalten dann per Zufallsprinzip die jeweils passende Version A oder Version B (Varianten).

Das folgende Bild veranschaulicht das Vorgehen etwas:

Das Schöne am A/B Testing: Die Ergebnisse können, nach einer bestimmten Zeit und/oder einer bestimmten Anzahl von Usern, mit Statistik berechnet und damit wissenschaftlich belegt werden. Erreicht ein A/B Test ein „signifikantes Level“ spricht man von statistischer Signifikanz. Mehr dazu aber weiter unten.

Wieso ist A/B Testing überhaupt wichtig?

Die meisten Unternehmen haben die Chancen, die durch strategisches und sinnvolles A/B Testing entstehen, einfach nicht auf dem Schirm. Stattdessen pumpen E-Commerce Seiten Unsummen an Geld in bezahlte Online Marketing Kanäle wie Facebook oder Google. Dadurch werden eine Menge Besucher auf die eigene Website gebracht, bei einer geringeren Konversionsrate werden diese Besucher aber nicht zu zahlenden Kunden.

Zudem wird bei vielen Unternehmen in einem Zyklus von 3 bis 5 Jahren eine neue Website erstellt. Die Design- und Entwicklungszeiten dieser neuen Website dauern oft Ewigkeiten und wenn die neue Seite dann live genommen wird, ist sie bereits am Tag der Veröffentlichung schon veraltet.

Außerdem haben immer die Unternehmen einen klaren Vorteil, die im Vergleich zu ihrer Konkurrenz auf kontinuierliches Testing von Funktionen setzen.

Erfolgreiche Unternehmen – nicht nur Amazon, Booking, YouTube und Co. – setzen daher auf eine iterative Weiterentwicklung ihrer Website durch strategisches A/B Testing. Kleinere Schritte, die sich nah am Besucher und den Kunden orientieren für bessere Erlebnisse auf der Website, einen besseren Service und optimiert für die Zielgruppe.

Evolution statt Revolution!

So sieht übrigens die Entwicklung von booking.com aus:

Welche Arten von A/B Tests gibt es?

In der Conversion Optimierung gibt es unterschiedliche Arten von A/B Tests. Dabei unterscheiden diese sich hauptsächlich durch die technische Art und Weise, im untergeordneten durch die eigentliche Strategie.

Der Vollständigkeit halber möchte ich dir die drei Testmethoden der Conversion Optimierung kurz vorstellen.

Klassisches A/B/n bzw. Split Testing

Die gängigste Testmethode ist der normale A/B/n bzw. Split Test. Hierbei gibt es, neben der Originalversion, mindestens immer eine Variante B. In den meisten A/B Testing Tools kann man eine oder mehrere Varianten anlegen.

Aus diesem Grund spricht man auch von A/B/n Testing. Das n kommt aus der Mathematik und steht für alle natürlichen Zahlen – in diesem Fall Buchstaben. Es kann sich also um einen A/B/C Test mit einer Originalversion (A) sowie zwei Varianten (B und C) handeln. Oder es könnte ein A/B/C/D/E/... Test sein mit beliebig vielen verschiedenen Varianten.

In der Praxis nutzt man diese Form der Split Tests – mit sehr vielen Varianten – allerdings nicht. Alternativ greift man dann lieber zum Multivariaten Testing.

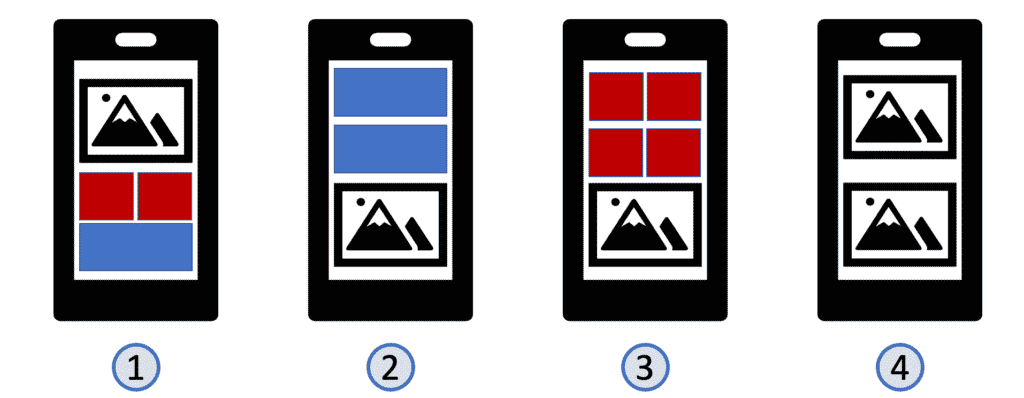

Multivariate Testing

Bei multivariaten Tests (oder Multivariate Testing) werden mehrere Variablen verändert. Während du bei normalen A/B Tests volle Kontrolle über die veränderte Variante hast, werden bei multivariaten Tests lediglich die einzelne Komponenten verändert. Diese veränderten Variablen werden dann von den A/B Testing Tools kombiniert und zu mehreren Versionen zusammengefügt.

Wenn du 3 verschiedene Varianten eines Call to Action Buttons hast und 4 verschiedene Varianten einer Headline, dann erhältst du in Summe 12 Split Tests.

[3 Call to Actions] x [4 Headlines] = 12 Split Tests

Der große Vorteil dabei ist, dass du diese 12 Kombinationsmöglichkeiten nicht als einzelne Split Test anlegen musst.

Allerdings ergibt die Methode des Multivariate Testing (MVT) oft nur bei Unternehmen mit vielen Besuchern überhaupt Sinn. Denn je mehr Varianten ein Test hat, desto mehr Traffic benötigst du für statistisch signifikante Ergebnisse.

Weiterleitungstests

Viele Marketer wollen gerne A/B Tests durchführen, in denen sie ganze Landingpages gegeneinander testen. Mithilfe eines Weiterleitungstests (Split URL Test) kann man genau das durchführen.

Der Ablauf ist sehr simpel:

Du baust zwei verschiedene Landingpages, welche unter zwei verschiedenen URLs erreichbar sind. Nehmen wir an, du hast eine Weihnachtskampagne mit der URL mywebsite.de/weihnachten-2022. Jetzt möchtest du ein ganz anderes Design und einen ganz anderen Aufbau dieser Landingpage testen und baust eine weitere Seite mit der URL mywebsite.de/weihnachten-2022-2.

Die A/B Testing Software geht jetzt her und teilt die einkommenden Website Besucher entsprechend auf: Manche der Besucher werden auf die Originalversion geschickt (mywebsite.de/weihnachten-2022) während andere diese Seite nie zu Gesicht bekommen, sondern direkt auf die veränderte Variante mywebsite.de/weihnachten-2022-2 (technisch) weitergeleitet werden.

Daher auch der Name Weiterleitungstest.

Ein Weiterleitungstest ist natürlich mit höherem Aufwand verbunden, denn je nach CMS und Website müssen Änderungen an beiden Seitenversionen durchgeführt werden. Oftmals ist diese Methode aber die sinnvollste, wenn es um das Testing von gänzlich unterschiedlichen Seiten geht.

Unser ISER Framework: Datengetrieben zu mehr Umsatz, Wachstum und Profitabilität ohne mehr Zeit und Geld für Werbung ausgeben zu müssen.

65+ erfolgreich betreute Kunden

Was kann alles getestet werden?

Wenn du A/B Tests durchführen kannst, kannst du nahezu alles auf deiner Website „auf die Probe stellen“ und optimieren. Angefangen bei der Kommunikation von Funktionen deiner Produkte bis hin zu sogenannten Behavior Patterns, bei denen du Elemente aus der Konsumpsychologie probieren kannst.

Dabei gibt es A/B Tests, die eher aus der Richtung User Experience kommen. Beispiele dafür sind

- Navigationsstruktur und -beschriftung

- Kontrastverhältnisse

- Abstände und Weißräume

- Akzentuierungen mit Farben

- Größe oder Form von Elementen

- und viele mehr

Call to Action Buttons kann man natürlich auch testen. Aber Vorsicht! Es macht keinen(!) Unterschied ob der Call to Action Button rot, blau, grün oder gelb ist. Bei den Berichten im Internet zu erfolgreich getesteten Farben liegt meist ein anderes Phänomen vor: Der Call to Action Button hatte einfach nicht genügend Kontrast im Vergleich zu den restlichen Elementen auf der Website.

Spannend sind vor allem die A/B Tests zu psychologischen Aspekten – sogenannte Behavior Patterns. Dabei lernst du einiges über das Denk- und Emotionsverhalten deiner Kunden bzw. Besucher. Um dich mit dem Thema vertraut zu machen, habe ich hier 5 Behavior Patterns, die du im Marketing kennen solltest, für dich.

Grundvoraussetzungen für erfolgreiches A/B Testing

Um mit A/B Testing starten und deine Website optimieren zu können, musst du lediglich einige technische und nicht-technische Grundvoraussetzungen erfüllen:

- Eine zu testende Website

- Ein A/B Testing Tool (zum Beispiel Google Optimize, Kameleoon, Optimizely, AB Tasty, o.ä.)

- Ein Analytics Tool (für die Arbeit mit Google Optimize musst du Google Analytics verwenden)

Das sind zumindest die technischen Voraussetzungen. Darüber hinaus solltest du aber noch zwei – meiner Meinung nach – essenzielle Fähigkeiten besitzen:

- Eine große Portion Neugierde und

- Die Überzeugung, dass der Status quo immer optimierbar ist und es nie eine perfekte Version gibt

Theoretische Vorgehensweise beim A/B Test

Du konntest bei den technischen und nicht-technischen Voraussetzungen nicken? Super, dann beantworte ich dir jetzt die Frage: Wie entwickelt man eigentlich einen A/B Test?

In der Theorie benötigt es dafür 4 Schritte:

- Die Identifizierung von Problemen auf deiner Website

- Die Definition einer angemessenen Hypothese

- Die Überlegung, welche Ziele das A/B Testing verfolgen soll und

- Die Erstellung der zu testenden Variante(n)

Identifizierung von Problemen auf deiner Website

Die Basis im A/B Testing bildet eigentlich immer ein existentes Problem der Website. Das kann, wie anfangs bereits kurz angerissen, ein Problem mit der Usability oder User Experience sein.

Manchmal sind Probleme mit der Usability auch No-Brainer. Wenn die Navigation auf mobilen Geräten beispielsweise nicht funktioniert, musst du nicht extra einen A/B Test durchführen. So etwas solltest du natürlich sofort beheben.

Mit psychologischen „Problemen“ meine ich, dass Menschen auf Signale wie Farben, vertrauensbildende Elemente, Bildsprache etc. unterschiedlich reagieren. Wirf dazu doch einen Blick in den Beitrag zu den 5 Behavior Patterns, die du im Marketing kennen solltest.

Doch auch Probleme der Customer Experience oder dass bestimmte Elemente für deine Website Besucher nicht sichtbar oder klar sind, eignen sich für eine Hypothese und einen anschließenden A/B Test.

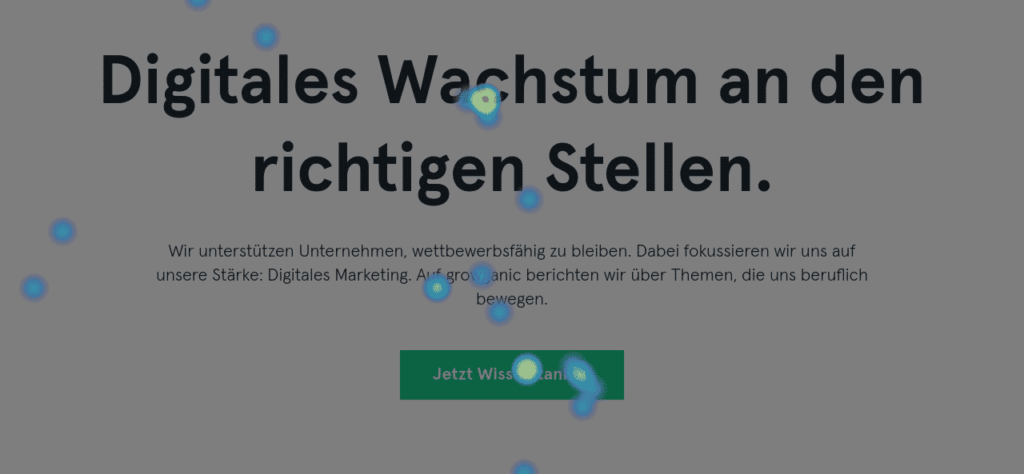

Probleme auf der Website lassen sich mit unterschiedlichen Methoden oder Tools identifizieren. Eine solide Datenbasis sollte als Grundlage für die Erstellung deiner Hypothesen dienen. Die folgende Liste ist ein kleiner Auszug und soll für dich als Gedankenanstoß dienen:

- Web-Analytics-Daten (Google Analytics, PIWIK, …)

- Heatmaps (Hotjar, Mouseflow, …)

- Screen- & Session-Recordings (Hotjar, Mouseflow, …)

- Onsite-Umfragen (Hotjar)

- Persönliche Interviews/Umfragen (Qualitativ, Quantitativ)

- …

Die Hypothese: Das Herzstück guter A/B Tests

Nehmen wir einmal Folgendes an:

Als du deine Website erstellt hast, fand der Designer oder die Agentur Textlinks anstelle von Buttons, weil diese besser zum Designs passen würden (und der Designer vielleicht gerade total auf Textlinks mit einem Pfeil steht).

Du hast auf deiner Website einiges an gutem Traffic, nur irgendwie meldet sich kaum jemand für den Newsletter an oder kauft die Produkte aus deinem Onlineshop.

Auf Grundlage der Daten aus dem Event-Tracking von Google Analytics geht möglicherweise hervor, dass Besucher kaum auf deine Call to Action Buttons klicken. Auch die mit Hotjar angelegten Heatmaps unterstützen diese Vermutung.

Das Problem würdest du jetzt gerne beheben und dafür einen A/B Test anlegen, also lass uns mal zusammen eine Hypothese aufstellen:

Wenn du die Darstellung deiner Call to Action Buttons prominenter gestaltest, dann erhöht sich die Clickrate, weil Nutzer durch den höheren Kontrast und die prominentere Gestaltung den Call to Action Button besser wahrnehmen.

Das wäre schon eine ganz gut formulierte Hypothese. Als Leitfaden kannst du dir das Wenn – Dann – Weil Muster merken:

Wennich Veränderung XY durchführe,dannverändert sich folgende Metrik,weilder Benefit für den Nutzer YZ ist.

Das schöne an diesem Framework ist, dass du alle relevanten Bausteine einer guten Hypothese abdeckst: Du gehst auf das Problem und die Lösung ein. Außerdem definierst du direkt eine Zielmetrik!

Ziel-Metriken beim A/B Testing

Durch das Anwenden des Wenn – Dann – Weil Frameworks bist du bereits gezwungen, dir eine sinnvolle Zielmetrik zu überlegen. Denn deine Zielmetrik, also der Wert, der sich verändern soll, steckt in der Weil Begründung.

Außerdem ergibt es manchmal Sinn, nicht in Makro-Conversions (also bspw. dem Kauf) zu denken, sondern sich auf Mikro-Conversions zu konzentrieren. Die Unterteilung in Mikro- und Makro-Conversions ist bei den meisten Tests durchaus sinnvoll, weil nicht jeder Test direkt zu mehr Käufen führt. Damit machst du zwar aus einem Website Besucher nicht direkt einen Kunden, ein Add-to-Cart wäre für viele E-Commerce Unternehmen, aufgrund von gut genutztem Retargeting, eine lohnenswerte Mikro-Conversion.

A/B Test Variante erstellen

Jetzt fehlt dir nur noch eine Variante, die dein identifiziertes Problem löst und im Anschluss als A/B Test gegen die bestehende Website ausgespielt werden kann. Dafür lohnt es sich gerade am Anfang, sich auf anderen Seiten inspirieren zu lassen und seine ersten Lösungsansätze zu skizzieren.

Das kannst du mit Papier und Stift, in Wireframing-Tools oder von einem Designer als Mockup bauen lassen. Je nachdem wie komplex die Variante ist und wie weit sie vom Original abweicht, macht eine eventuell reellere Ausgestaltung mehr Sinn. Aber das ist immer vom Kontext abhängig.

Wie du mit Google A/B Testing betreibst, erfährst du in dem Beitrag wie du einen A/B Test mit Google Optimize anlegst.

Auswertung des A/B Tests

Um im A/B Testing auch fundierte Aussagen über die Veränderungen treffen zu können, ist ein Grundverständnis von Statistik definitiv von Vorteil.

Die beiden wichtigsten Begriffe dabei sind Konfidenzniveau und Signifikanzniveau.

Das Konfidenzniveau gibt an, mit welcher Wahrscheinlichkeit die ermittelten Werte der Stichprobe auch für die Grundgesamtheit gelten. Konkret bedeutet das: Dein Test erhebt Daten einer Stichprobe (die Besucher in dem A/B Test). Aber nur weil bestimmte Werte für die Stichprobe vorliegen, bedeutet das ja noch nicht, dass diese Werte allgemein für „alle“ deine Website Besucher gelten. Im Regelfall geht man von einem Konfidenzniveau von 95% aus.

Das Signifikanzlevel hingegen beschreibt eine Irrtumswahrscheinlichkeit. Geht man von einem Konfidenzniveau von 95% aus, liegt die Irrtumswahrscheinlichkeit bei 5% (100% – 95%). Das bedeutet: Wir akzeptieren mit einer Wahrscheinlichkeit von 5%, dass die Ergebnisse aus dem A/B Test falsch sind und die Variante eventuell nicht die bessere Version ist.

Diese Werte für das Konfidenzniveau und Signifikanzniveau sind in der Statistik und Forschung gängig. Es gibt aber auch die Möglichkeit, das Konfidenzniveau für A/B Tests herabzusetzen. Je nach Szenario kann ein Konfidenzniveau von 85% oder 90% ebenfalls Sinn ergeben.

Wichtig dabei ist eben zu wissen, was das Konfidenzniveau bedeutet und wie die Auswirkungen auf meine Wahrscheinlichkeit eines Fehlers sind.

Die häufigsten Fehler bei A/B Tests

Beim A/B Testing kommt es natürlich auch immer wieder zu Fehlern. Das kann nicht nur für die Tests richtig doof sein, sondern sich auch auf die Conversion Rate auswirken und deiner Website nachhaltig schaden.

- Den Test zu schnell beenden

Dein Split Test läuft jetzt 4 Tage und die Werte sehen gut aus? Alles klar, dann schnell beenden und ausrollen. Doch auch wenn der Test vielleicht nicht so anläuft, wie geplant und sich langsam Panik breit macht: In keinem Fall solltest du deinen Test frühzeitig beenden. Als grobe Faustregel kann man sich merken, dass ein Test 14 Tage laufen sollte. Wenn deine Website allerdings sehr viel Traffic und sehr viele Conversions pro Tag generiert, kann das natürlich auch schneller gehen bis man signifikante Werte aus dem Test erhält. - Zu wenig Daten

Be A/B Testing dreht es sich um Wahrscheinlichkeiten und Statistik. Wenn ein Unternehmen im Monat lediglich 5 Conversions macht, dann müssten die A/B Tests des Unternehmens ewig laufen. - Wild drauf los testen

Sinnvolles A/B Testing erfordert Planung, Priorisierung von Tests und eine Roadmap an die sich die involvierten Personen halten sollten - Zu komplexe Tests zu Beginn

Gerade wenn man mit A/B Testing beginnt, sollten die Tests nicht allzu komplex sein. Du solltest lieber mit etwas Leichtem starten und die Anforderung an die Tests mit der wachsenden Erfahrung erhöhen. - Du testest nicht alles

In meinem Kopf herrscht eineTest everythingMentalität. Nur weil jemand (im Zweifel der Chef) Funktion X super toll findet, heißt das noch nicht, dass diese Funktion ohne Testing ausgerollt wird. Es gibt etliche Beispiele von A/B Tests, die bei einer Website sehr gut performt haben und bei einer anderen Website den gegenteiligen Effekt zeigten. Insofern: Test everything!

So etablierst du A/B Testing in deinem Unternehmen

In manchen Unternehmen können A/B Tests auf Widerstand stoßen. Der „Umweg“, der über A/B Tests gemacht wird, wird als lästiger Mehrauwand gesehen und man drängt darauf, die Änderungen gleich umzusetzen. Wenn du damit ankommst, einen Test durchführen zu wollen, sind möglicherweise nicht alle begeistert.

Nach und nach eine Kultur des Experimentieren und datengetriebenen Verändern der Websites zu schaffen, kann zwar vielleicht mühsam erscheinen, lohnt sich aber auf lange Sicht auf jeden Fall.

Hier sind ein paar Tipps, wie du die Testbereitschaft in deinem Unternehmen erhöhst.

- A/B Test Ergebnisse dienen als Argumente: Wenn im Nachhinein die Führungsebene mit Elementen oder Ergebnissen nicht zufrieden sind, habt ihr die A/B Test Ergebnisse als Argument, warum die Änderung auf der Website sinnvoll war.

- Irren ist menschlich: Nicht selten gewinnt bei A/B Tests die Variante, die intuitiv als weniger gut wahrgenommen wird. Indem du ein paar solche Beispiele mit überraschenden Ergebnissen auf Lager hast, kannst du Test-Skeptiker leichter überzeugen

- Datengetriebene Optimierung ist die Königsstrategie: Wenn das Unternehmen datengetrieben arbeitet und wichtige Geschäftsbereiche gemessen und optimiert werden, warum sollte das nicht auch für Elemente auf der Website gelten?

A/B Testing Tools sind häufig nicht gerade günstig. Aber bereits ein positiver Test kann die Ausgaben um ein Vielfaches wieder reinbringen.

Hier kannst du das Potenzial von einer Conversionoptimierung berechnen.

Auch hierfür solltest du Rechenbeispiele bereithalten, um deine Geschäftspartner oder Vorgesetzte von der absoluten Sinnhaftigkeit von A B Testing zu überzeugen.

Die Grenzen von A/B Testing

So überzeugt wir auch vom A/B Testing sind und so sinnvoll die datengetriebene Optimierung vielfach auch ist, es gibt auch ein paar Grenzen von A/B Tests.

A/B Testing kann nur Tests mit messbaren Variablen optimieren. Wenn es um die unbewussten Gefühle der Zielgruppe geht oder das unbewusste Bild von deiner Marke, das deine Website hervorruft, sind A/B Tests die falsche Methode.

Außerdem liefert A/B Testing keine neue Ideen, sondern kann nur existierende Ideen bestätigen oder widerlegen. Sollen komplett neue, innovative Ideen getestet werden, kann es sein, dass diese nicht in dein Testing-Framework passen oder zu kompliziert sind.

Wenn du dir aber bewusst bist, wo die Stärken von A/B Tests liegen und für welche Inhalte sie geeignet sind, stellen sie eine mächtige Waffe in deinem Marketing-Toolkoffer dar.

Fazit

Ich selbst bin ein riesiger Freund von A/B Testing und den Möglichkeiten, die diese Disziplin bietet.

Der spannendste Punkt dabei ist sicherlich, dass du mehr über deine Kunden lernen kannst und wirst. Das Eintauchen in die Zahlenwelt und das Hineinversetzen in den Website Besucher machen dabei enorm viel Spaß und gleich ein bisschen dem Verfolgen von Hinweisen wie bei Sherlock Holmes.

Hoffentlich konntest du einen guten Einstieg in das Thema gewinnen, falls du noch Fragen hast schreib mir gerne ein Kommentar unter dem Artikel.